AI芯片赛道热潮 国“芯”能否弯道超车

2023-07-12 13:31:58 来源:哔哥哔特商务网 作者:廖正世 点击:10959

英伟达市值冲破万亿美元大关给AI芯片赛道点燃了一把火。

单日暴涨2000亿美元,首个跻身万亿俱乐部的芯片制造商,创下历史上最大的单日涨幅,英伟达一时间风头无两。

一向触觉敏锐的资本也纷纷果断下场。短短几周,英伟达就吸引了至少100家ESG基金的投资,并成为这些资产管理公司最受欢迎的股票之一。

英伟达股市的疯狂以及大量资本的涌入,将人们的注意力狠狠地拽进了AI芯片这一赛道。

英伟达的老对手AMD也随之发布了最新的MI300X芯片,目标直指英伟达。AI芯片这一块蛋糕谁都不想错过,而AMD股市今年的涨幅也达到了90%。

正如人们津津乐道的“卖铲子”的故事一样,在淘金热时期,早早赚得盆满钵满的不是那些淘金的工人,而是卖铲子给他们的人。

从去年年底发布的大语言生成式模型ChatGPT3.5,到今年爆火的生成式AI——Midjourney,随着AI的狂风刮起,处于风口的AI芯片就被吹上了天。

那么AI芯片是什么?为什么突然就火了?我们国内的芯片厂商有可能分到大块的蛋糕吗?

带着这三个问题,我们继续往下寻找答案。

AI芯片实质上是一个处理乘法和加法运算的计算器

一般来说,AI芯片是指用来运行AI算法的专用处理器,与普通的芯片最大的区别在于专用性的侧重上。

目前AI的实现包含了两个环节——训练、推理。

其中训练是指通过大数据训练出一个复杂的神经网络模型,通常需要对自然语言、图像、语音等海量数据进行AI算法处理,本质上来说是矩阵或向量的乘法、加法。那么AI芯片在其中扮演的角色就是一个执行乘法和加法的计算器,所以对计算性能的要求比较高。

再拿最常见的CPU和GPU来举例。

CPU和GPU同样都可以执行AI算法,但从架构上来说CPU因为需要处理很多的逻辑运算,所以它的计算单元(ALU)只占据一小部分,大概仅有20%,GPU的ALU能占到80%。而算力恰恰是AI芯片最需要的,所以CPU的AI算法执行效率就会远低于GPU。简而言之AI芯片就是牺牲通用性来换取特性。

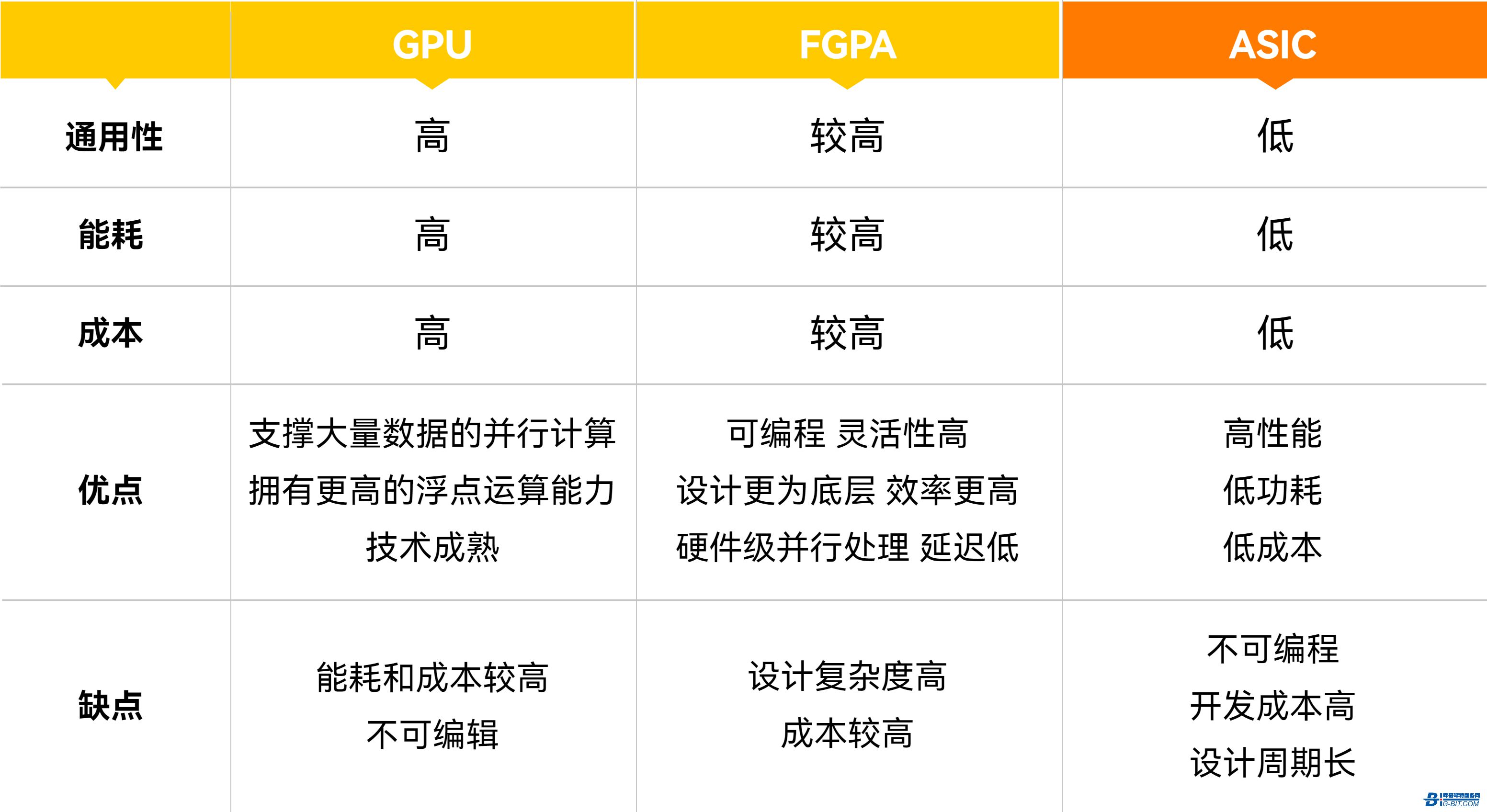

目前主流的AI芯片大概分为GPU、FGPA、ASIC这三类,以及距离大规模商用还有一段距离的类脑芯片等。

从GPU到ASIC就是一条从通用(GPU)到半定制(FGPA)再到定制(ASIC)的过程。

AI芯片分类对比图

GPU(Graphics Processing Unit),即图形处理器,是一种由大量核心组成的大规模并行计算架构,专为同时处理多重任务而设计。GPU芯片的设计初衷是为了应对图像处理中需要大规模并行计算,而在算法方面也更加针对图像渲染。

但处理并行计算这一点与执行AI算法的需求不谋而合,于是GPU芯片最早作为深度学习算法的芯片被引入人工智能领域,在数据中心中获得大量应用。生产GPU芯片的厂商后续也专门针对AI算法做出优化,推出了专门适配AI的GPU芯片产品。

FPGA(Field-Programmable Gate Array),即现场可编程门阵列,是一种可编程逻辑器件,其设计初衷是为了实现半定制芯片的功能,即硬件结构可根据需要实时配置灵活改变,它可以被编程为实现各种数字电路功能。

FPGA芯片的功能非常强大,可以实现多种数字电路功能,例如逻辑运算、加减乘除、数据处理、存储控制等。与其他数字电路元件不同,FPGA芯片的功能可以通过编程来实现,因此可以快速适应不同的应用场景,同时也可以方便地修改和更新功能。FPGA芯片在数字信号处理、图像处理、网络通信、嵌入式系统设计等领域得到广泛应用。

ASIC(Application Specific Integrated Circuits),即专用集成电路是一种为专用目的设计的,面向特定用户需求的定制芯片。

ASIC芯片与GPU芯片和FPGA芯片不同,GPU芯片和FPGA芯片除了是一种技术路线之外,还是实实在在的确定的产品,而ASIC芯片就是一种技术路线或者方案,其呈现出的最终形态与功能也是多种多样的。在大规模量产的情况下AISC芯片具备性能更强、体积更小、功耗更低、成本更低、可靠性更髙等优点。

目前市场上AI服务器中应用最广泛的是GPU芯片。有资料显示,英伟达的GPU芯片为市场AI服务器搭建的主流选择,主要型号为A100/H100芯片,目前大约占据60%-70%的份额,其次为云计算厂商自主研发的ASIC芯片,市占率逾20%。

一卡难求源自于AI算力的胃口越来越大

尽管目前H100芯片的价格已经涨到了4万美元/枚,仍一卡难求。有业内人士透露H100芯片的订单已经排到了2024年,在供需关系的影响下A800/H800芯片的价格涨幅也达到了40%。

市场需求的火爆源自于AI市场对算力的胃口越来越大,算力高的芯片已成为AI赛道的硬通货。

据Google云平台的AI基础设施负责人Amin Vahdat观察,过去6年来,模型规模每年都增长了十倍。驱动ChatGPT的最新版本GPT-4用于分析数据的参数有1万亿个,是上一个版本的五倍。随着模型越来越复杂,训练它们所需要的算力也会随之增长。

除了ChatGPT的升级,目前主流的AI厂商都已经进入了“千亿数据时代”,“超过千亿数据的大模型训练大概要1000~2000张A100,没有2000张A100,实验都做不了”,昆仑万维集团CEO方汉在此前公开表示。

前段时间,微软为了给Chatgpt和Bing提供更好的算力,斥资几亿美元,耗费上万张A100芯片打造超算平台。马斯克也购买了上万张GPU芯片用于自己的AI公司数据训练,并评论道:“这玩意儿(英伟达GPU)比药品还难搞”。

除开生成式AI,诸如数据中心、自动驾驶、安防、手机终端等AI领域也需要大量的算力和芯片。

“我们已到达生成式AI引爆点。从此,全世界的每个角落,都会有计算需求。”黄仁勋在此前的台北电脑展(COMPUTEX 2023)大会上表示。

国产芯片仍有追赶空间

除了大量购入芯片以外,很多公司也开始研发自己的芯片以求得在此次大潮中获取主动。

诸如Google、Amazon等科技巨头其实早早就已经下场,Amazon已经推出了Trainium和Inferentia两款AI芯片,而Google的TPU也早已更新到了第四代。

微软在近日被爆出其内部早在2019年就开始在内部开发代号为“雅典娜”的芯片,希望可以为价值高昂的人工智能工作节省成本。

Mate公司也在近日收购了英国AI芯片独角兽Graphcore的AI网络技术团队,披露其正在构建首款专门用于运行AI模型的定制芯片——MTIA(Meta Training and Inference Accelerator)芯片,预计于2025年问世。

其实国内各科技巨头也都早展开布局。例如,百度于 2011 年成立了昆仑芯,开始探索芯片领域;阿里巴巴在 2018 年成立了平头哥,专注于 AI 芯片市场。华为同样一直在人工智能芯片领域进行布局,早在 2017 年就推出了基于神经网络处理器的 Ascend 芯片,主要面向人工智能推理场景。

虽然目前AI芯片市场上仍是国外厂商占据了大部分的市场份额,但并没有形成完全垄断的局面。

国内半导体行业,正持续加大投入力度,资本市场芯片领域也获得了资金净流入。当前国内规模最大的芯片类指数基金——芯片ETF(159995)在今年上半年,累计获得资金净申购近34亿份,目前份额总数达到238亿份,资金规模达到247.57亿元。

再加上自去年以来,中国在高端AI芯片领域持续受到美国方面的制裁,以及近日中国对美国镓、锗限制出口的反击。这一切的都利好国内的AI芯片发展,国产AI芯片仍有奋力追赶的空间。

国内AI芯片产品对比(图源民生证券研报)

早在“十三五”规划中,人工智能芯片就被写入国家发展规划纲要,一批AI芯片企业也随之成立。得益于国家的前瞻布局,国内AI芯片技术早已有从0到1的突破,与国外的差距正在慢慢缩小。

以下是一些国内的领头企业。

寒武纪成立于 2016 年,公司研发团队成员主要来自于中科院。寒武纪 AI 芯片思元 290 芯片面向云端训练,思元 370 芯片面向云端训推一体,两款芯片均采用 7nm 制程工艺。此外,思元 370 芯片是寒武纪首款采用 chiplet 技术的 AI 芯片,最大算力高达 256TOPS;训练侧新品思元 590 芯片在研发中。

寒武纪也推出了面向开发者的寒武纪人工智能软件平台Cambricon NeuWare,这是在终端和云端的AI芯片共享的软件接口和生态,包含开发、调试和调优三大部分,体现了创始人陈天石提出的“端云一体”的思路。

海光信息成立于 2014 年,公司骨干研发人员多拥有国内外知名芯片公司的就职背景,拥有成功研发 x86 处理器或 ARM 处理器的经验。海光信息的 DCU 芯片深算一号采用 7nm 工艺,兼容“类 CUDA”环境,软硬件生态丰富,已于 2021年实现规模化出货,未来将广泛应用于大数据处理、人工智能、商业计算等领域。

沐曦集成电路成立于 2020 年,公司创始团队处于国内顶尖行列——创始人陈维良曾任 AMD 全球 GPGPU 设计总负责人;两位 CTO 均为前 AMD 首席科学家,目前分别负责公司软硬件架构;核心成员平均拥有近 20 年高性能 GPU 研发经验。沐曦首款异构 GPU 产品 MXN100 芯片采用 7nm 制程,已于 2022 年 8 月回片点亮,主要应用于推理侧;应用于 AI 训练及通用计算的产品 MXC500 芯片已于 2022 年 12 月交付流片,公司计划 2024 年全面量产。

国内AI芯片公司对比(图源民生证券研报)

天数智芯成立于 2015 年,首席科学家郑金山为原 AMD 首席工程师,首席技术官 Chien-Ping Lu 曾任三星全球副总裁。天数智芯的 Big Island 云端 GPGPU 是一款具有自主知识产权、自研 IP 架构的 7nm 通用云端训练芯片,这款芯片达到295TOPS INT8 算力。

壁仞科技成立于 2019 年,创始人张文曾任商汤科技总裁,CTO 洪洲曾任职于海思的 GPU 自研团队,软件生态环境主要负责人焦国方曾创建高通公司骁龙GPU 团队、领导了 5 代 Adreno GPU 架构开发。2022 年 8 月,壁仞科技发布首款 GPGPU 芯片BR100,BR100 芯片采用 chiplet 技术,其 16 位浮点算力达到 1000T 以上、8 位定点算力达到 2000T 以上。

纵观半导体行业的历史发展,我们会发现无论是90年代的PC,还是今天的智能手机,芯片才是底层的技术驱动力和竞争力。早几年华为凭着自研芯片在高端智能手机市场与苹果平分秋色,在芯片受到制裁之后便一落千丈,这是我们看见的事实。

国内由于入局比较晚的原因,在电脑芯片以及手机芯片上都很难赶上国外的发展,而目前AI芯片的发展仍处于初级阶段,无论是科研还是产业应用都还有很长的路要走。这这条赛道上国产芯片完全有机会实现弯道超车。毕竟比赛才刚刚开始。

本文为哔哥哔特资讯原创文章,未经允许和授权,不得转载,否则将严格追究法律责任;

航顺芯片不涨价告知函

本文针对数字隔离器中常见两种典型的电路拓扑类型的变压器,结合对应的芯片,给出了从安规距离设定和关键电气特性计算的实际案例,为工程设计人员提供设计和应用参考。

得益于尖端技术的进步,彩虹效应已几乎不复存在。现代单芯片DLP®投影仪拥有时尚的全新设计、高刷新率,以及LED和RGB激光等新型照明技术。

1 月 29 日,专注于 RISC-V 架构的领军企业进迭时空举办线上发布会,正式推出新一代 AI CPU 芯片 K3。这款历经 1200 余天研发的产品,

前TI工程师评出2026年五大高性价比MCU/SoC,体现从“低价”到“单位成本功能密度”的性价比新标准。榜单反映RISC-V崛起、AIoT下沉及特色外设集成三大趋势。

极海正式发布G32M3101系列高性能、高性价比、高集成电机控制SoC,集成“MCU+LDO+栅极驱动器”三合一单芯片方案,进一步降低了系统成本和PCB面积,提升系统效率与可靠性。

第一时间获取电子制造行业新鲜资讯和深度商业分析,请在微信公众账号中搜索“哔哥哔特商务网”或者“big-bit”,或用手机扫描左方二维码,即可获得哔哥哔特每日精华内容推送和最优搜索体验,并参与活动!

发表评论